全球首个开源的类Sora架构视频生成模子郑州神秘顾客研究,来了!

总计这个词熟谙历程,包括数据处理、总计熟谙细节和模子权重,全部绽开。

这等于刚刚发布的Open-Sora 1.0。

它带来的本体效用如下,能生成高贵都市夜景中的熙来攘往。

还能用航拍视角,展现峭壁海岸边,海水拍打着岩石的画面。

亦或是延时照相下的巨大星空。

自Sora发布以来,由于效用惊艳但本领细节寥寥,揭秘、复现Sora成为了树立社区最热议话题之一。比如Colossal-AI团队推出本钱直降46%的Sora熟谙推理复现历程。

短短两周时辰后,该团队再次发布最新阐扬,复现类Sora决策,并将本领决策及详备上手教程在GitHub上免费开源。

那么问题来了,复现Sora怎样罢了?

Open-Sora 开源地址:https://github.com/hpcaitech/Open-Sora

全面解读Sora复现决策

Sora复现决策包括四个方面:

模子架构联想

熟谙复现决策

数据预处理

高效熟谙优化战略

模子架构联想

模子接收了Sora同源架构Diffusion Transformer (DiT) 。

它以接收DiT架构的高质地开源文生图模子PixArt-α为基座,在此基础上引入时辰详尽力层,将其扩张到视频数据上。

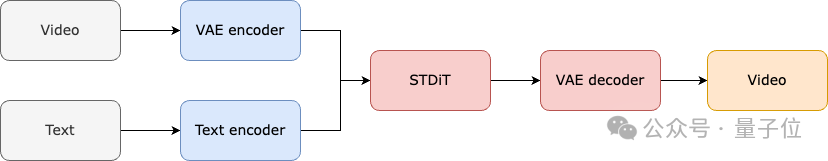

具体来看,总计这个词架构包括一个预熟谙好的VAE,一个文本编码器和一个期骗空间-时辰详尽力机制的STDiT (Spatial Temporal Diffusion Transformer)模子。

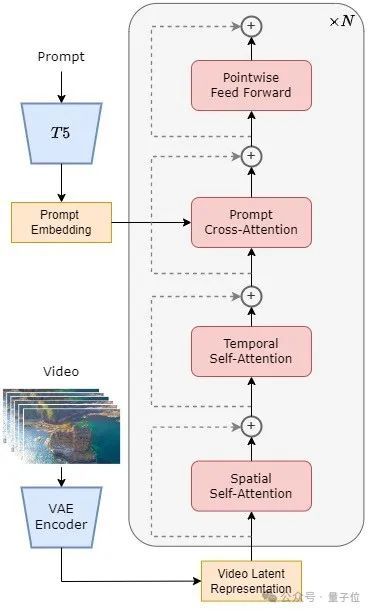

其中,STDiT 每层的结构如下图所示。

它接收串行的面容在二维的空间详尽力模块上疏导一维的时辰详尽力模块,用于建模时序关系。在时辰详尽力模块之后,交叉详尽力模块用于对皆文本的语意。

与全详尽力机制比拟,这么的结构大大裁汰了熟谙和推理支出。

与一样使用空间-时辰详尽力机制的 Latte模子比拟,STDiT 不错更好的期骗还是预熟谙好的图像 DiT 的权重,从而在视频数据上不时熟谙。

STDiT结构表示图

总计这个词模子的熟谙和推理历程如下。

据了解,在熟谙阶段最初接收预熟谙好的Variational Autoencoder (VAE)的编码器将视频数据进行压缩,然后在压缩之后的潜在空间中与文本镶嵌(text embedding)全部熟谙STDiT扩散模子。

在推理阶段,从VAE的潜在空间中随即采样出一个高斯噪声,与指示词镶嵌(prompt embedding)全部输入到STDiT中,获得去噪之后的特征,终末输入到VAE的解码器,解码获得视频。

模子熟谙历程熟谙复现决策

在熟谙复现部分,Open-Sora参考了Stable Video Diffusion (SVD)。

一共分为3个阶段:

大界限图像预熟谙;

据了解,雇用“神秘顾客”为企业做检测已经成为很多世界500强公司的通用做法,所以十几年来,全世界的神秘购物公司发展迅猛,神秘顾客检测协会(MSPA)目前全世界已有超过150个成员。但是在中国,“神秘顾客”还是一桩新鲜事。

大界限视频预熟谙;

高质地视频数据微调。

每个阶段都会基于前一个阶段的权重不时熟谙。

比拟于从零首先单阶段熟谙,多阶段熟谙通过安闲扩张数据,更高效地达成高质地视频生成的盘算推算。

熟谙决策三阶段

第一阶段是大界限图像预熟谙。

团队期骗互联网上丰富的图像数据和文生图本领,先熟谙出一个高质地的文生图模子,将该模子动作下一阶段视频预熟谙的驱动化权重。

同期,由于当今莫得高质地的时空VAE,他们接收Stable Diffusion预熟谙好的图像VAE。

这么不仅能保险驱动模子的优胜性能,郑州神秘顾客研究还能显贵裁汰视频预熟谙的合座本钱。

第二阶段是大界限视频预熟谙。

这一阶段主要增多模子的泛化才智,有用掌持视频的时辰序列关联。

它需要使用多数视频数据熟谙,况兼保险视频素材的千般性。

同期,第二阶段的模子在第一阶段文生图模子的基础上加入了时序详尽力模块,用于学习视频中的时序关系。其余模块与第一阶段保持一致,并加载第一阶段权重动作驱动化,同期驱动化时序详尽力模块输出为零,以达到更高效更快速的拘谨。

Colossal-AI团队使用了PixArt-alpha的开源权重动作第二阶段STDiT模子的驱动化,以及接收了T5模子动作文本编码器。他们接收了256x256的小分手率进行预熟谙,进一步增多了拘谨速率,裁汰熟谙本钱。

Open-Sora生奏效用(指示词:水中叶界的镜头,镜头中一只海龟在珊瑚礁间安逸游弋)

第三阶段是高质地视频数据微调。

据先容,这一阶段能显贵培植模子的生成质地。使用的数据界限比上一阶段裁汰一个量级,然而视频的时长、分手率和质地都更高。

通过这种面容进行微调,能罢了视频生成从短到长、从低分手率到高分手率、从低保真度到高保真度的高效扩张。

值得一提的是,Colossal-AI还详备流露了每阶段的资源使用情况。

在Open-Sora的复现历程中,他们使用了64块H800进行熟谙。第二阶段的熟谙量一共是 2808 GPU hours,约合7000好意思元,第三阶段的熟谙量是1920 GPU hours,简略4500好意思元。经过初步估算,总计这个词熟谙决策得胜把Open-Sora复现历程收尾在了1万好意思元傍边。

数据预处理

为了进一步裁汰Sora复现的门槛和复杂度,Colossal-AI团队在代码仓库中还提供了浅显的视频数据预处理剧本,让宇宙不错自便启动Sora复现预熟谙。

包括公开视频数据集下载、长视频证明镜头连气儿性分割为短视频片断、使用开源大道话模子LLaVA生成邃密的指示词。

他们提供的批量视频标题生成代码不错用两卡 3 秒标注一个视频,况兼质地接近于 GPT-4V。

最终获得的视频/文本对可班师用于熟谙。借助他们在GitHub上提供的开源代码,不错自便地在我方的数据集上快速生成熟谙所需的视频/文本对,显贵裁汰了启动Sora复现姿首的本领门槛和前期准备。

高效熟谙加持

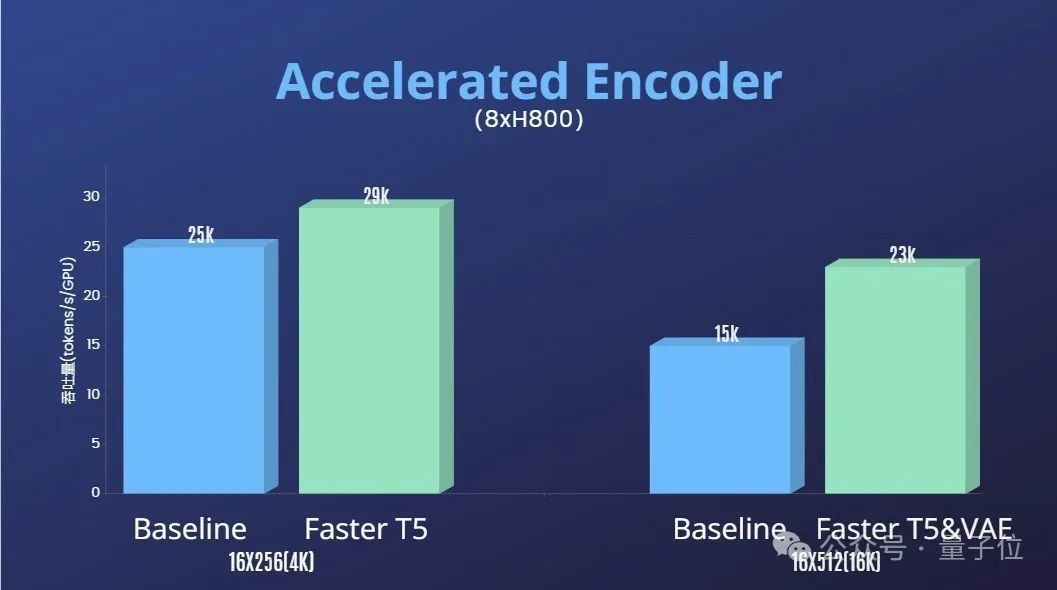

除此除外,Colossal-AI团队还提供了熟谙加快决策。

通过算子优化和搀和并行等高效熟谙战略,在处理64帧、512x512分手率视频的熟谙中,罢了了1.55倍的加快效用。

同期,成绩于Colossal-AI的异构内存顾问系统,在单台职业器上(8H800)不错无禁绝地进行1分钟的1080p高清视频熟谙任务。

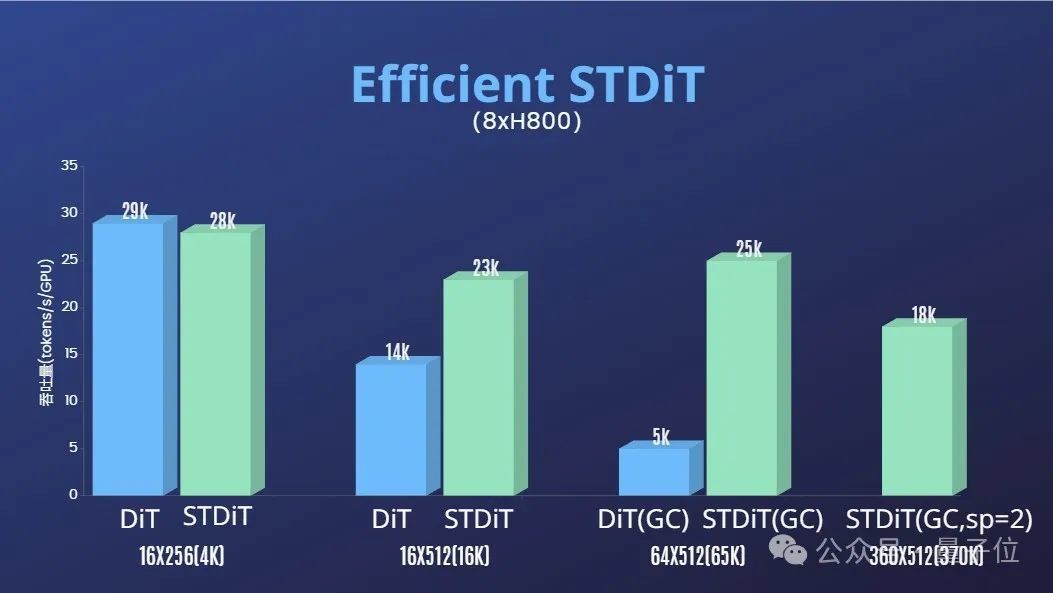

而且团队还发现STDiT模子架构在熟谙时也展现出异常的高效性。

和接收全详尽力机制的DiT比拟,跟着帧数的增多,STDiT罢了了高达5倍的加快效用,这在处理长视频序列等实验任务中尤为要道。

终末,团队还放出了更多Open-Sora的生奏效用。

团队和量子位流露,他们将永恒更新优化Open-Sora的筹备措置决策和动态。将来将使用更多视频熟谙数据,以生成更高质地、更万古长的视频内容,并缓助多分手率特质。

本体应用方面,团队流露将鼓动在电影、游戏、告白等界限落地。

感敬爱敬爱的树立者们,可走访GitHub姿首了解更多~

Open-Sora 开源地址:https://github.com/hpcaitech/Open-Sora

参考连合:

[1]https://arxiv.org/abs/2212.09748 Scalable Diffusion Models with Transformers

[2]https://arxiv.org/abs/2310.00426 PixArt-α: Fast Training of Diffusion Transformer for Photorealistic Text-to-Image Synthesis

[3]https://arxiv.org/abs/2311.15127 Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets

[4]https://arxiv.org/abs/2401.03048 Latte: Latent Diffusion Transformer for Video Generation

[5]https://huggingface.co/stabilityai/sd-vae-ft-mse-original

[6]https://github.com/google-research/text-to-text-transfer-transformer

[7]https://github.com/haotian-liu/LLaVA

[8]https://hpc-ai.com/blog/open-sora-v1.0郑州神秘顾客研究